TL;DR

- Chain of X 시리즈 중 Document를 보고 Multi-step Reasoning을 시도하였다.

- CoD 방식은 정보 정확성이 낮은 문서와 모르는 질문에 대해서도 Robust하게 답변한다.

- 리트리빙 이후 질문에 대한 passage 정제가 매우 필요해 보인다.

Intro

요즘 Retrieval-augmented language models (RALMs)들은 다음과 같은 문제가 있다.

- 관련 없는 데이터에 대한 검색을 할 경우 고유한 지식을 간과하여 질문과 관계없는 답변을 배출한다.

- 정보에 대한 평가가 이루어지지 않기 때문에 정확한 답변을 제공하기 위해 내재적 지식과 검색된 지식 모두에서 적절한 지식을 보유하고 있는지 평가하는 데 어려움을 겪는 경우가 많습니다.

따라서 우리는 정보를 제공할 수 없을 시, "제공할 수 없음"으로 배출하는 과정을 겪어야한다.

이러한 과정을 겪을 수 있도록 우리는 Chain-of-Noting(CoN)을 제안. 따라서 Noise와 관련성 없는 문서 확인 그리고 unknown 시나리오에 대해 Facing할 수 있도록 방법을 제안.

- Noise Robustness: The ability of a RALM to discern and disregard noisy information present in irrelevant retrieved documents, while appropriately leveraging its intrinsic knowledge.

- Unknown Robustness: The capacity of a RALM to acknowledge its limitations by responding with “unknown” when given a query it does not have the corresponding knowledge to answer, and the relevant information is not found within the retrieved documents.

따라서 평가를 3가지 방향으로 잡고 진행하는데, 데이터는 ODQA(TriviaQA), WebQ, RealTimeQA를 사용

- overall QA performance using DPR-retrieved documents

- noise robustness, assessed by introducing noisy information to the system

- unknown robustness, evaluated through queries not covered in the LLaMa-2 pre-training data, i.e., real-time questions.

Method

- Note Design

-

- Retrieved document(RD)에 정답에 대한 다이렉트 정보가 있는 경우

- RD에 정답에 대한 정보가 애매하게 있는 경우

- RD에 정답에 대한 정보가 아예 없거나 관련이 없는 경우3가지 format에 대한 데이터 생성

-

- Data generate

- ChatGPT를 활용하여 생성

- NQ 에서 1만개 랜덤샘플링하여 지정 프롬프트를 사용하여 note 생성

- Training

- LLaMa-2 7B을 사용

- 일반적인 Loss를 사용할 시 input size가 너무 길어 수렴이 안됌 => Weighted Loss on Notes and Answers전략을 사용

- 시간을 기준으로 (?) 실제 정답 y에 대한 NTP수행 50%, 나머지 50%는 모든 document가 들어간 input에 대한 y의 NTP 수행

실험

Unknown성능을 제외하고 NQ, TriviaQA, WebQ 세가지 Benchmark dataset을 활용하여 측정, Unknown은 RealTimeQA를 사용한다.

그리곤 전체 QA에 대해서 한번, noise와 unknown에 대해서 한번 실험을 통해 결과를 보여준다.

noise와 unknown 측정 시, 관련 없는 문서를 추출하기 위해 노이즈의 비율을 r이라고 notation하자면

$k \cdot r$ 이 관련없는 문서의 비율이다. 이 갯수를 채울때 까지 iter돌려서 list로 받는다.

- QA 성능

- NQ, TriviaQA, WebQ 3가지 task의 EM, F1스코어로 측정

- Noise 성능

- 리트리빙 된 문서를 하나 제거한 후, 관련없는 top k 1개 문서와 완전 랜덤 wiki 문서 하나를 추가한 성능을 비교한다.

- 노이즈가 많으면 할루시네이션이 엄청나다는 것을 알 수 있지만, CoN으로 학습된 모델은 비교적 덜 영향을 받는 것으로 보여진다.

- ![[Pasted image 20231121142801.png]]

- Unknown 성능

'AI > Paper-review' 카테고리의 다른 글

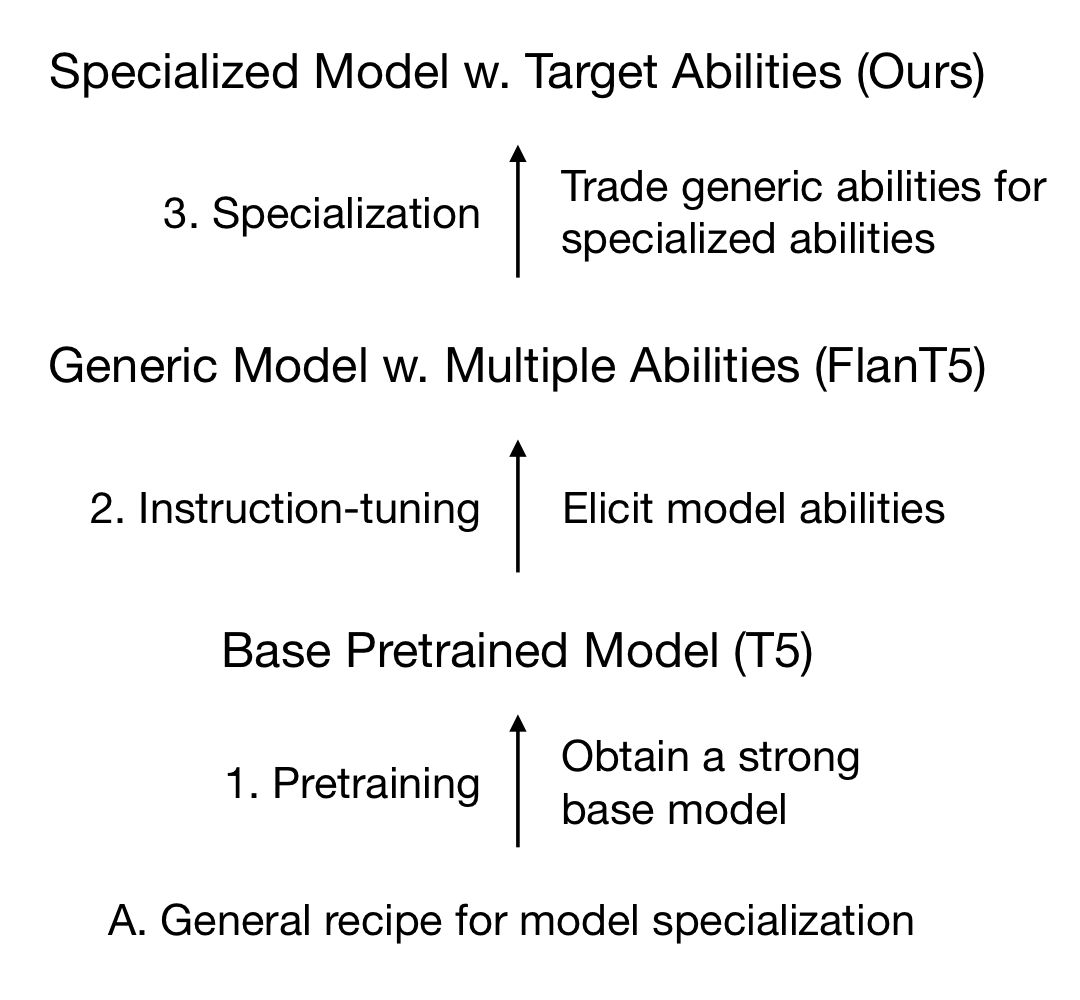

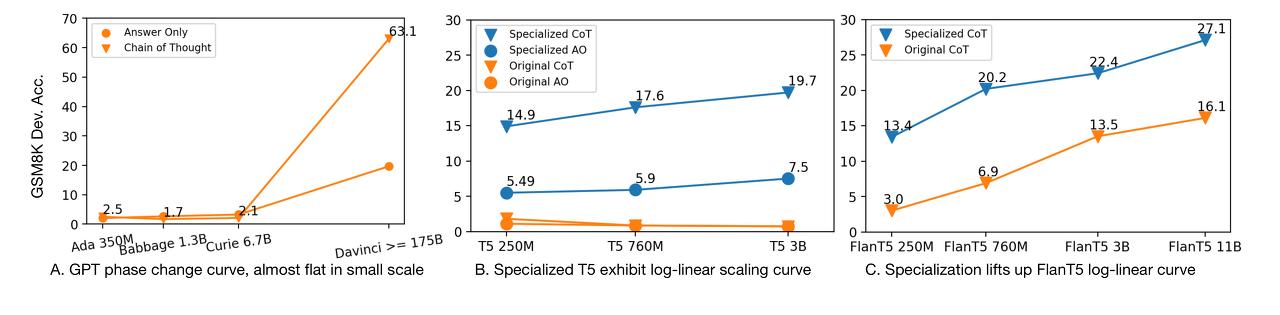

| [Paper Review] Specializing Smaller Language Models towards Multi-step Reasoning (2) | 2023.04.15 |

|---|